Member Content

Warum du das lesen solltest: Als Cybersecurity-Experte erkenne ich die gleichen Argumente wieder, die 1986 eine internationale Spionage-Operation fast verhindert hätten. Heute höre ich sie bei AI Governance. Als jemand, der beide Welten kennt, will ich zeigen, warum wir die Fehler der Vergangenheit nicht wiederholen dürfen - bevor es zu spät ist.

Meine Perspektive: Zwischen den Welten

Nach Jahren in der Cybersecurity-Branche wechsle ich zunehmend in die AI Governance. Und dabei erlebe ich ein erschreckendes Déjà-vu. Die Argumente, die Verharmlosungen, die bürokratischen Ausreden – alles schon mal gehört, wenn auch nicht selbst erlebt. Als jemand, der 1983 geboren wurde und erst ab etwa 16/17 Jahren mit Internet und Computersicherheit in Berührung kam, kenne ich die frühen Cybersecurity-Geschichten aus Berichten, Büchern und den Erzählungen der Pioniere. Aber die Muster erkenne ich sofort wieder – nur dass die Technologie heute exponentiell mächtiger ist und die Zeitfenster zum Handeln dramatisch kürzer sind.

Die folgende Geschichte zeigt, wohin "zu klein zum Handeln" führen kann.

1986: Als 75 Cent fast die nationale Sicherheit kosteten

Clifford Stoll, Astronom am Lawrence Berkeley National Laboratory, bekommt 1986 einen scheinbar banalen Auftrag: Eine Buchhaltungsdiskrepanz von 75 Cent aufklären.

Die meisten hätten das als Rundungsfehler abgetan. Stoll nicht. Er ruft das FBI an und bekommt die Antwort: "Ein Verlust von 75 Cent rechtfertigt keine Untersuchung." CIA, NSA, Department of Energy – alle winken ab. Zu klein. Nicht ihre Zuständigkeit. Kein Budget dafür.

Clifford Stoll 2017 (Credit: Wikipedia)

Was Stoll dann in zehn Monaten mühsamer Eigenarbeit aufdeckt, ist atemberaubend: einen internationalen KGB-Spionagering, der militärische Geheimnisse zu Rüstungsprojekten stahl. Markus Hess, der "Hannover Hacker", hatte sich Zugang zu Los Alamos National Laboratory, Militärbasen und Verteidigungsunternehmen verschafft. Alles begann mit 75 Cent, die "zu unwichtig" waren.

Die vergessenen Opfer: Mittelständische Defense Contractors

Was in den meisten Berichten über den Fall untergeht: Die Hacker nutzten systematisch mittelständische Rüstungsunternehmen als Sprungbretter zu größeren militärischen Netzwerken. Firmen wie Mitre, TRW, Unisys und BBN – heute würde man sie als "KMUs mit sensiblen Aufträgen" bezeichnen. Diese Unternehmen versagten bei grundlegenden Sicherheitspraktiken: Default-Passwörter, fehlende Patches, mangelhaftes Log-Monitoring.

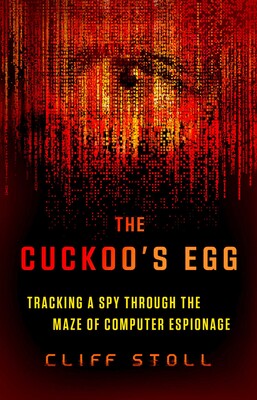

Warum? Weil Cybersecurity für sie "zu teuer" und "nicht geschäftskritisch" war. Sie konzentrierten sich auf ihre Kernkompetenzen – Rüstungstechnik, Forschung, Entwicklung. IT-Sicherheit war ein lästiger Kostenfaktor. Bis sie zum schwächsten Glied in der nationalen Sicherheitskette wurden. Clifford Stoll beschrieb das alles in seinem Buch ‚The Cuckoos Egg‘.

The Cuckoos Egg beschriebt den gesamten Fall (Credit: Verlag)

2025: Die gleichen Argumente, exponentiell gefährlichere Technologie

Heute, fast 40 Jahre später, höre ich in AI Governance-Diskussionen exakt die gleichen Phrasen: "Die AI-Risiken sind zu spekulativ, um jetzt zu regulieren." "Lass uns abwarten, bis ein echter Schaden eintritt." "Wir sollten nicht überreagieren wegen theoretischer Szenarien."

Kleinere AI-Vorfälle werden systematisch als Einzelfälle abgetan. Ein biased Algorithmus in der Personalauswahl wird "optimiert". Deepfake-Betrug ist ein Problem der "Medienkompetenz". Ungenaue AI-Diagnosen sind kein Problem, "der Arzt prüft ja noch mal". Manipulierte Bewerbungssysteme regelt die "Marktbereinigung".

Und wieder sind es die KMUs, die außen vor bleiben. Während Großkonzerne eigene AI-Ethics-Teams aufbauen, kämpfen mittelständische Unternehmen mit den Grundlagen: Welche AI-Tools dürfen wir nutzen? Wie schützen wir Kundendaten? Was passiert, wenn unsere AI-gestützten Prozesse fehlerhaft sind?

Währenddessen akkumulieren sich die "75-Cent-Momente" unserer Zeit: Jeder ignorierte Bias in AI-Systemen, jede Sicherheitslücke, die "später gepatcht" wird, jedes autonome System, das ohne ausreichende Kontrollen deployed wird. Die Muster sind identisch, nur die Technologie ist unvergleichlich mächtiger geworden.

Der entscheidende Unterschied zu 1986

Hier wird es kritisch: 1986 konnte Stoll den Hacker monatelang verfolgen. Systeme waren isoliert, Schäden blieben begrenzt. Heute skalieren AI-Systeme global in Millisekunden. Einmal trainierte Modelle können nicht einfach "zurückgerufen" werden wie Software-Updates. Die Zeitfenster zum Handeln sind dramatisch kürzer, die potentiellen Auswirkungen exponentiell größer.

Bei DECAID haben wir das verstanden. Unsere KI-Richtlinie basiert auf dem Prinzip: "Von der schlechtesten KI ausgehen" – realistische Erwartungen setzen und proaktiv handeln, nicht reaktiv. Als jemand, der die Cybersecurity-Entwicklung seit den 2000ern miterlebt und die frühen Geschichten intensiv studiert hat, weiß ich: Präventive Governance ist immer günstiger als nachträgliche Schadensbegrenzung.

Besonders für KMUs gilt: Lieber heute pragmatische Leitplanken als morgen existenzbedrohende Krisen.

Die unbequeme Wahrheit aus 40 Jahren Tech-Geschichte

Die größten Systemrisiken kündigen sich selten mit Fanfaren an. Sie beginnen als Anomalien, die "zu klein sind, um sich darum zu kümmern." 1986 brauchte es einen hartnäckigen Astronomen, der nicht lockerließ. 2025 brauchen wir Governance-Frameworks, bevor wir unseren "KGB-Moment" mit AI erleben.

Der Unterschied? Bei Cybersecurity hatten wir Jahrzehnte Zeit zum Reagieren und Nachbessern. Bei AI-Systemen, die sich selbst verbessern und global skalieren, sind diese Luxus-Zeitfenster Geschichte.

Als jemand, der die Cybersecurity-Entwicklung seit 2011 professionell verfolgt und die historischen Fälle intensiv studiert hat, kann ich nur sagen: Wir haben die Chance, es diesmal besser zu machen. Aber nur, wenn wir aus der Geschichte lernen, statt sie zu wiederholen.

Was war dein "75-Cent-Moment" – eine kleine Anomalie, die auf etwas Größeres hindeutete?

Bei diesem Artikel hatte ich digitale Unterstützung: KI hat beim Research und beim Formulieren geholfen, die Endredaktion und inhaltliche Verantwortung liegen bei mir als Autor.

.svg)

.svg)

0 Comments

Login or Register to Join the Conversation

Create an AccountLog in