Member Content

Warum du das lesen solltest: 1983 saß ein 17-Jähriger vor dem US-Kongress, nachdem er in Atomwaffenlabore eingebrochen war. Die Verharmlosung von damals ("nur ein neugieriger Teenager") höre ich heute bei AI-Risiken wieder. Als Cybersecurity-Experte, der jetzt in AI Governance arbeitet, erkenne ich die erschreckenden Parallelen aus den historischen Berichten.

Zwischen Cybersecurity und AI Governance: Ein Blick zurück

Nach Jahren in der Cybersecurity-Welt wechsle ich zunehmend in die AI Governance – und erlebe dabei ein beunruhigendes Déjà-vu. Die Verharmlosungsstrategien, die ich aus den Berichten über die frühen Tage der Computersicherheit kenne, werden heute eins zu eins bei AI-Risiken angewandt. Als jemand, der 1983 geboren wurde und die Cybersecurity-Szene seit 2011 professionell verfolgt, kenne ich diese Geschichten aus intensiver Recherche und den Erzählungen der Pioniere. Nur dass die Technologie heute exponentiell mächtiger geworden ist.

Diese Geschichte aus 1983 zeigt, wohin Verharmlosung führt.

26. September 1983: Ein Teenager schreibt Geschichte

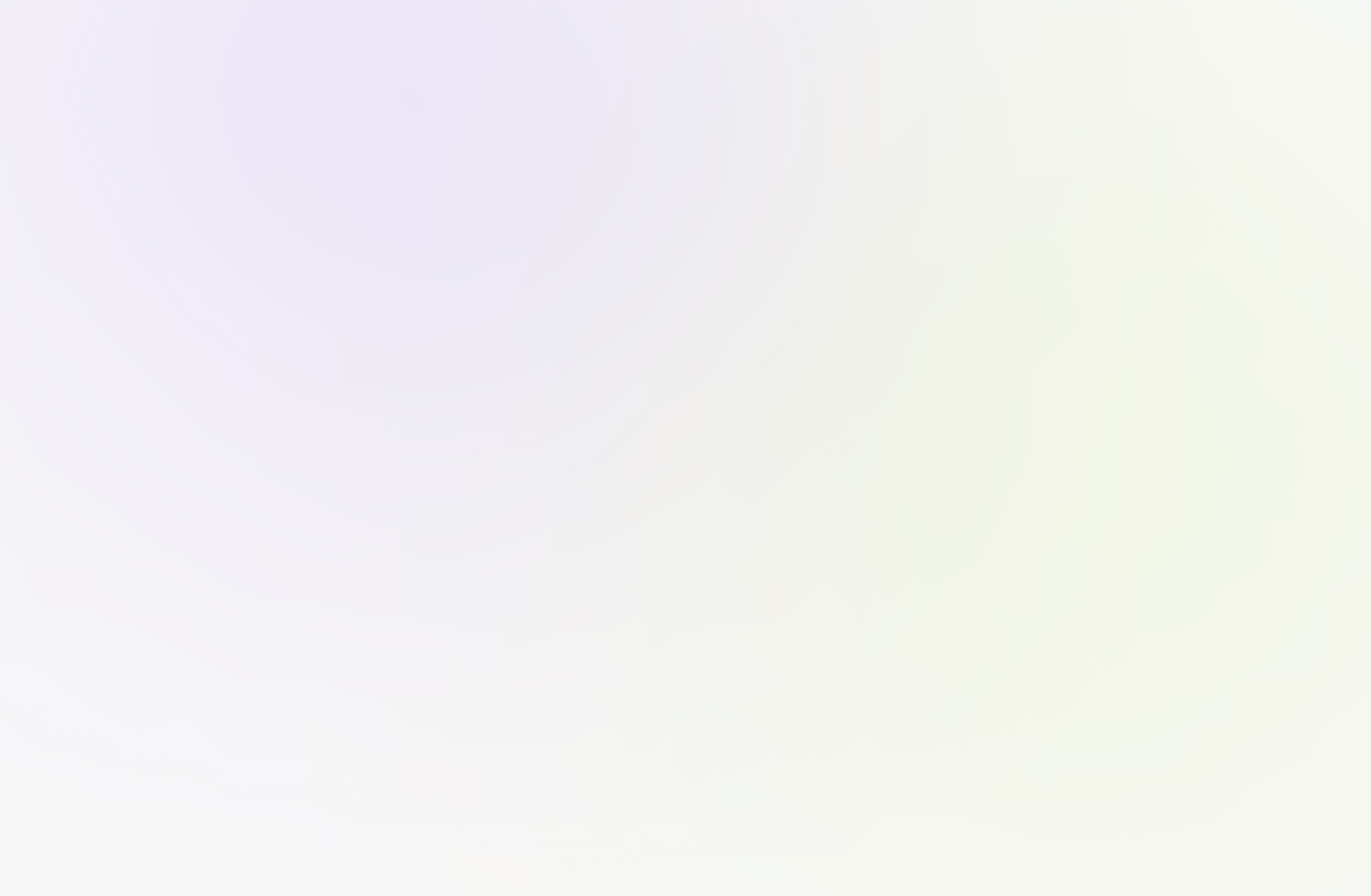

Neal Patrick, 17 Jahre alt, Highschool-Schüler aus Milwaukee, sitzt vor dem US-Kongress. Er ist Teil der "414s"-Hackergruppe, benannt nach der Milwaukee-Vorwahl. Was hatte dieser "harmlose Teenager" getan? Er war in Los Alamos National Laboratory eingebrochen – dort, wo Atomwaffen entwickelt werden. Außerdem hatte er das Sloan-Kettering Cancer Center gehackt, die Security Pacific National Bank kompromittiert und Dutzende weitere hochsensible Systeme geknackt.

Newsweek Cocer mit Neal Patrick (credit: commons.wilipedia.org)

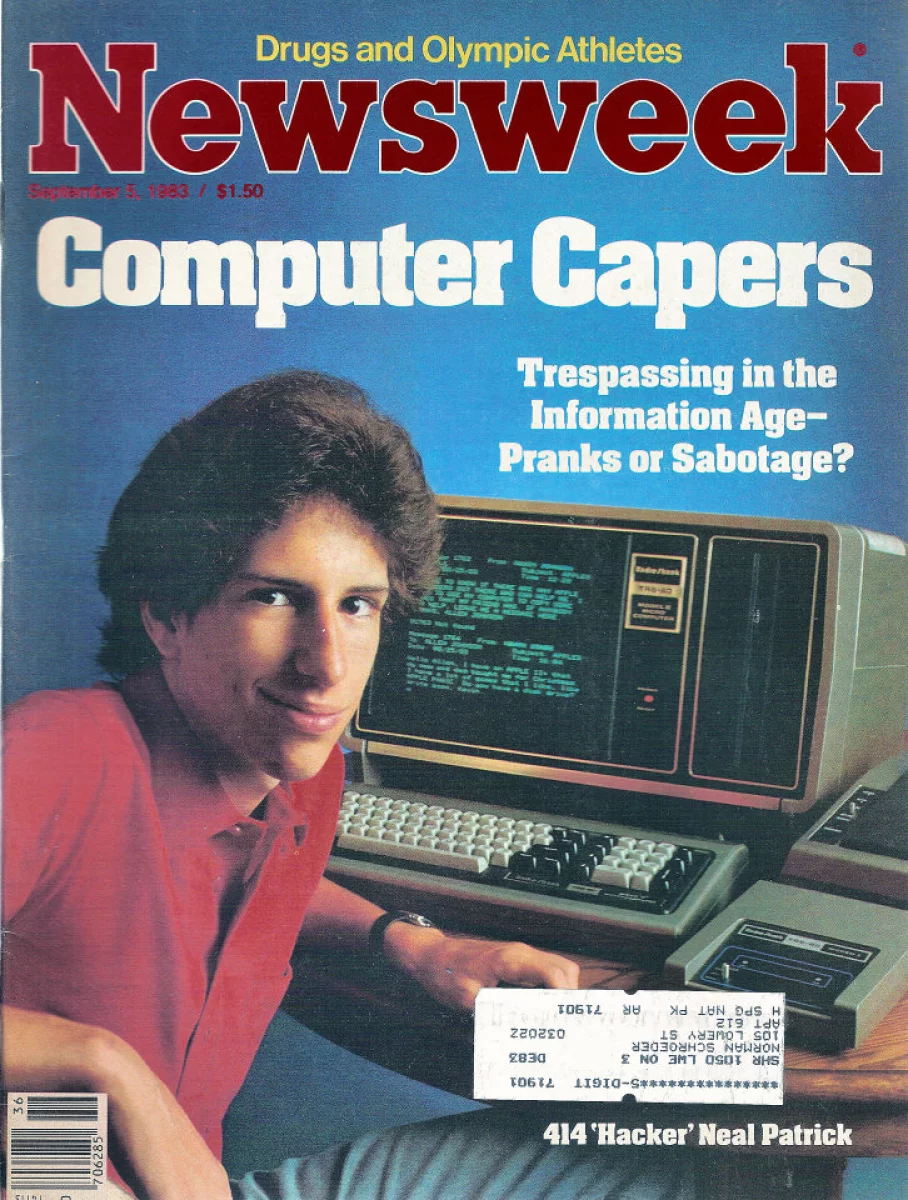

Seine Motivation war denkbar simpel: "Ich wollte WarGames nachspielen und Videospiele auf ihren Computern spielen." Ein Teenager, der aus Langeweile in die sensibelsten Computersysteme der USA einbricht – das hätte ein Weckruf sein müssen.

Die große Verharmlosung von 1983

Stattdessen hörte man überall: "Nur ein neugieriger Teenager." "Kein böswilliger Akteur – nur ein schlauer Junge, der sich langweilt." "Boys will be boys." Neal Patrick testierte vor dem Kongress, während neben ihm Jim McCleary, Division Leader of Operational Security bei Los Alamos, verlegen erklären musste, wie ein 17-Jähriger all seine Sicherheitssysteme umgangen hatte.

Das größte Problem war nicht der Hack selbst, sondern die rechtliche Lücke: Es gab 1983 praktisch keine Gesetze gegen das, was Patrick getan hatte. Der Computer Fraud and Abuse Act wurde erst 1986 verabschiedet – drei Jahre nach diesem Vorfall. Die Industrie argumentierte erwartungsgemäß: "Wir brauchen keine neuen Gesetze", "Das sind Einzelfälle", "Lasst uns die Kids nicht kriminalisieren", "Die Systeme sollten einfach besser gesichert sein".

Interessant ist, dass es einen Hollywood-Film brauchte, damit die Politik handelte. Erst als Präsident Reagan "WarGames" sah und fragte: "Could something like this really happen?" – und die Joint Chiefs bestätigten: "Yes" – begann echte politische Action.

Das Original Filmplakat von 1983 (Credit: originalfilmart.com)

2025: Die gleiche Verharmlosung, exponentiell gefährlichere Technologie

Heute, über 40 Jahre später, höre ich als AI Governance-Experte exakt die gleichen Argumente: "AI ist nur ein Tool – es kommt darauf an, wie Menschen es nutzen." "Die Technologie selbst ist neutral." "Wir sollten nicht Innovation bestrafen wegen ein paar Missbrauchsfällen."

Währenddessen zerstört Deepfake-Pornografie Leben, aber es sind "nur ein paar schlechte Akteure". AI-generierte Desinformation beeinflusst Wahlen, aber "Medienkompetenz ist die Lösung". Autonomous weapons werden entwickelt, aber "andere Länder machen es auch". Ungetestete AI-Systeme werden in kritische Infrastruktur integriert, aber "wir lernen durch Experimente".

Die Parallelen sind frappierend: 1983 hieß es "Es sind nur neugierige Kinder" – bis sie in Atomwaffenlabore einbrachen. 2025 heißt es "Es sind nur Tools" – bis was genau passiert?

Der kritische Unterschied zu 1983

Bei DECAID verstehen wir: "KI wie ein Teammitglied behandeln" – mit klaren Erwartungen und Rollen. Aber auch die besten Teammitglieder brauchen Regeln und Grenzen. Der entscheidende Unterschied zu 1983 ist die Geschwindigkeit und Skalierung: Damals konnte man ein Computersystem ausschalten und neustarten. Heute kannst du ein trainiertes AI-Modell nicht einfach "zurückrufen", wenn es in Millionen Anwendungen integriert ist.

Original Filmausschnitt „War Games“ (Credit: imdb.com)

Bei Cybersecurity brauchten wir einen Teenager in Los Alamos, einen Hollywood-Film, eine präsidiale Direktive und trotzdem noch drei Jahre bis zum ersten Gesetz. Bei AI haben wir nicht den Luxus von Jahrzehnten des Trial-and-Error. Die Technologie skaliert zu schnell, die potentiellen Auswirkungen sind zu groß, die Zeitfenster zum Handeln sind zu kurz.

Aus der Geschichte lernen, nicht sie wiederholen

Als jemand, der die Cybersecurity-Entwicklung seit 2011 professionell verfolgt und die historischen Fälle intensiv studiert hat, ist die Frage nicht OB wir AI governen müssen, sondern ob wir proaktiv handeln oder reaktiv – nach unserem "Los Alamos-Moment". Und im Gegensatz zu 1983 könnten wir beim zweiten Versuch keine Chance mehr bekommen.

Die Geschichte lehrt uns: Verharmlosung ist der erste Schritt zum Systemversagen. Lass uns diesmal klüger sein.

Bei diesem Artikel hatte ich digitale Unterstützung: KI hat beim Research und beim Formulieren geholfen, die Endredaktion und inhaltliche Verantwortung liegen bei mir als Autor.

.svg)

.svg)

0 Comments

Login or Register to Join the Conversation

Create an AccountLog in